Welcome to the Next Generation

The AI image generation landscape just got a major upgrade with the release of Z-Image-Turbo, a cutting-edge model that promises faster generation times without sacrificing quality. But how do we objectively measure its capabilities? That’s where this comprehensive benchmark suite comes in.

I’ve crafted 10 specialized prompts designed to stress-test every critical aspect of modern image generation: photorealistic skin rendering, accurate text placement, complex physics simulation, atmospheric lighting, and surreal concept blending. Whether you’re a seasoned prompt engineer or just curious about what Z-Image-Turbo can do, this benchmark pack gives you a standardized, repeatable way to evaluate performance.

Why Benchmarking Matters

With new models dropping constantly, it’s easy to get lost in hype and marketing claims. A structured benchmark suite cuts through the noise by testing specific technical challenges that historically trip up AI models:

- Text rendering (the eternal struggle of legible signage)

- Material complexity (glass, metal, fabric, organic surfaces)

- Physics simulation (motion blur, liquid dynamics, cloth behavior)

- Atmospheric effects (fog, smoke, volumetric lighting)

- Conceptual coherence (can it blend impossible ideas convincingly?)

By running these 10 prompts on Z-Image-Turbo—and sharing your results—you contribute to a community understanding of where the model excels and where it still needs work.

The 10 Benchmark Prompts

1. Text Rendering & Reflection Test

What it tests: Can Z-Image-Turbo render specific, legible text on challenging surfaces like wet glass while managing complex reflections?

The Challenge: This prompt combines three historically difficult elements: coherent text, realistic water droplets, and neon light reflections distorted by glass. Look for clean typography on the « MIDNIGHT RAMEN » sign and check if the « OPEN 24/7 » sticker remains readable despite condensation.

{

"subject": "A rainy night neo-noir street scene focusing on a cafe window",

"appearance": "A steamy glass window with condensation droplets running down, reflecting neon red and blue city lights",

"action": "N/A (Static scene)",

"setting": "Tokyo back alley, midnight, rain-slicked asphalt",

"lighting": "Cinematic neon lighting, red and blue hues clashing, high contrast",

"atmosphere": "Melancholic, wet, humid, moody",

"composition": "Close-up on the window glass with the interior slightly blurred",

"details": "Silhouettes of people inside, raindrops distorting the light, a stray cat under an awning in the background",

"text_elements": "Neon sign in window reading \"MIDNIGHT RAMEN\" in stylized retro font, small sticker on glass reading \"OPEN 24/7\"",

"technical": "Shot on Sony A7R IV, 35mm lens, f/1.8, focus on raindrops, bokeh background",

"trigger_word": ""

}

2. Subsurface Scattering & Skin Test

What it tests: Realistic human skin with micro-details like pores, freckles, and the translucent glow of light passing through skin tissue.

The Challenge: The botanist’s face should show individual freckles, visible skin texture, and realistic subsurface scattering where the mushroom’s purple light illuminates her features. Zoom in to check for fine details like the peach fuzz on her cheeks and the sweat droplet.

{

"subject": "Elara, a 28-year-old freckled botanist",

"appearance": "Pale skin with visible pores and heavy freckles, messy auburn hair tied back with a vine, wearing a dirty linen shirt",

"action": "Holding a glowing bioluminescent mushroom up to inspect it closely",

"setting": "A humid, glass-walled greenhouse filled with exotic giant ferns",

"lighting": "Strong backlighting from the sun entering the glass, soft purple glow from the mushroom illuminating her face",

"atmosphere": "Dusty air, pollen particles floating, warm and organic",

"composition": "Extreme close-up (Macro) on the face and the mushroom",

"details": "Dirt under fingernails, fine peach fuzz on cheeks, sweat droplet on temple",

"text_elements": "Tag on her shirt pocket reading \"STAFF\"",

"technical": "Macro lens 100mm, f/2.8, subsurface scattering enabled, sharp focus on eyes",

"trigger_word": ""

}

3. Complex Material & Geometry Test

What it tests: Rendering of premium materials (marble, gold, velvet) and symmetrical architectural patterns with accurate reflections.

The Challenge: The Art Deco lobby demands crisp geometric patterns, mirror-like marble floors that reflect the chandelier, and distinct material properties for gold inlays versus velvet furniture. Check if « THE GRANDEUR HOTEL » text remains clean and properly integrated into the marble desk.

{

"subject": "Interior of a futuristic Art Deco grand hotel lobby",

"appearance": "Polished black marble floors with gold inlays, towering geometric statues, velvet red furniture",

"action": "A robot concierge waiting patiently",

"setting": "New York City, year 2150, luxury district",

"lighting": "Warm chandelier lighting, volumetric god rays from high windows, polished reflections",

"atmosphere": "Opulent, clean, quiet, majestic",

"composition": "Wide angle symmetrical shot centered on the reception desk",

"details": "Intricate geometric patterns on the ceiling, holographic dust motes",

"text_elements": "Gold lettering on the marble desk reading \"THE GRANDEUR HOTEL\"",

"technical": "Architecture photography, tilt-shift lens, 8k resolution, ray-tracing style",

"trigger_word": ""

}

4. Action & Motion Blur Test

What it tests: The model’s ability to freeze action while maintaining realistic motion blur and particle physics.

The Challenge: Look for individual mud clods suspended in mid-air with convincing trajectories. The rider and bike should be sharp while the background trees show directional motion blur. The « TURBO-Z » logo should be legible despite the dynamic angle.

{

"subject": "A motocross racer mid-jump",

"appearance": "Rider wearing bright orange and blue Fox Racing gear, helmet with mirrored visor, mud-spattered boots",

"action": "Doing a 'whip' trick in the air, bike turned sideways, mud flying off the tires",

"setting": "Outdoor dirt track, sunset, crowd in the background",

"lighting": "Golden hour sunlight hitting the dust, harsh shadows",

"atmosphere": "Energetic, dusty, loud, chaotic",

"composition": "Low angle looking up at the rider against the sky",

"details": "Individual clods of dirt suspended in air, motion blur on the background trees",

"text_elements": "Sponsor logo on the bike side panel reading \"TURBO-Z\"",

"technical": "Shutter speed 1/4000s, sports photography, high contrast, freeze motion",

"trigger_word": ""

}

5. Food & Liquid Dynamics Test

What it tests: Appetizing food texture, steam simulation, and the physics of ingredients mid-fall.

The Challenge: The burger should look genuinely delicious with visible grease on the bun, cheese stretching as it melts, and sesame seeds frozen in mid-air. Rising steam should be visible and convincing, not just a blur effect. The « DELISH » flag should be sharp.

json

{

"subject": "A gourmet double cheeseburger smash",

"appearance": "Two beef patties with crispy edges, melting cheddar cheese dripping down, glistening brioche bun, fresh lettuce and tomato",

"action": "Being dropped onto a wooden table with ingredients slightly separating from impact",

"setting": "Dark rustic kitchen studio",

"lighting": "Dramatic side lighting to emphasize texture, rim light on the grease",

"atmosphere": "Appetizing, high-end commercial",

"composition": "Eye-level shot, shallow depth of field behind the burger",

"details": "Sesame seeds in mid-air, ketchup droplet flying, steam rising from the meat",

"text_elements": "A small flag toothpick in the bun reading \"DELISH\"",

"technical": "Food photography, 85mm lens, crisp details, color graded warm",

"trigger_word": ""

}

6. Fur & Crowd Test

What it tests: Multiple distinct characters with consistent anatomy, detailed fur rendering, and complex scene coherence.

The Challenge: Each of the 15 dogs should look unique with recognizable breed characteristics. Fur should show individual strand detail where lighting permits. Check that clothing accessories (vests, hats, bowties) sit naturally on dog anatomy. The « NO CATS ALLOWED » sign adds a text-in-background challenge.

{

"subject": "A chaotic meeting of 15 different dogs playing poker",

"appearance": "Bulldogs, Poodles, and Huskies wearing varying human clothes (vests, hats, bowties)",

"action": "Sitting around a green felt table, one dog throwing chips in, another hiding an ace",

"setting": "Smoky underground speakeasy, 1920s style",

"lighting": "Dim overhead lamp casting a cone of light on the table",

"atmosphere": "Hazy with cigar smoke, vintage, humorous",

"composition": "Overhead view slightly angled down",

"details": "Poker chips stacked, whiskey glasses, cigars in ashtrays",

"text_elements": "Sign on the wall in background \"NO CATS ALLOWED\"",

"technical": "Oil painting style texture, Norman Rockwell influence, high detail on fur",

"trigger_word": ""

}

7. Fabric & Drapery Test

What it tests: Cloth physics, transparent and reflective material combinations, and motion capture of flowing fabric.

The Challenge: The gown should show distinct properties for the iridescent plastic (reflective, stiff) versus sheer silk (translucent, flowing). The fabric should billow naturally behind the model as if caught by runway wind. « VOGUE 2025 » text should be crisp and properly scaled on the wall.

{

"subject": "A high-fashion model walking a runway",

"appearance": "Tall androgynous model, sharp cheekbones, wearing a flowing gown made of liquid iridescent plastic and sheer silk",

"action": "Walking confidently, the dress billowing dramatically behind",

"setting": "Paris Fashion Week runway, minimalist white background",

"lighting": "Harsh white studio flashes, minimal shadows",

"atmosphere": "Sterile, chic, high-energy, modern",

"composition": "Full body shot from the end of the runway",

"details": "Reflections on the plastic fabric, texture of the sheer silk, audience silhouettes",

"text_elements": "Large bold typography on the wall behind reading \"VOGUE 2025\"",

"technical": "Fashion editorial, Phase One camera, ultra-sharp resolution",

"trigger_word": ""

}

8. Horror & Low Light Test

What it tests: Atmospheric dread, noise handling in dark scenes, and the ability to create tension without relying on brightness.

The Challenge: This is the mood test. The animatronic should genuinely look creepy, not cartoony. The flickering fluorescent should create harsh, uneven shadows. VHS grain and chromatic aberration should add to the found-footage feel without destroying detail. The red graffiti « IT’S ME » should be legible but disturbing.

{

"subject": "An abandoned animatronic bear in a hallway",

"appearance": "Rusted metal exoskeleton showing through torn synthetic fur, one eye hanging out by a wire, dirty teeth",

"action": "Slumping against a peeling wallpaper wall",

"setting": "Derelict 1980s family pizza restaurant, hallway to the restrooms",

"lighting": "Flickering fluorescent light bulb overhead, mostly darkness",

"atmosphere": "Terrifying, stale, claustrophobic, grainy",

"composition": "Dutch angle (tilted), point-of-view shot from a flashlight beam",

"details": "Checkered floor tiles covered in dust, old party hat on the floor",

"text_elements": "Graffiti on the wall scrawled in red reading \"IT'S ME\"",

"technical": "Found footage style, VHS grain overlay, chromatic aberration, low ISO noise",

"trigger_word": ""

}

9. Landscape & Scale Test

What it tests: Vast environmental rendering, sense of scale, atmospheric perspective, and detail retention at distance.

The Challenge: The human figure should be barely visible, emphasizing the monumentality of the gate. Intricate runes carved into stone should be visible despite the distance. Swirling snow and prayer flags add motion to an otherwise static landscape. The overcast lighting should feel genuinely cold and harsh.

{

"subject": "A lone explorer standing before a massive ancient gate",

"appearance": "Tiny figure in a red poncho, carrying a walking stick",

"action": "Looking up at the monument",

"setting": "A snowy mountain range in the Himalayas, the gate is carved into the mountain face",

"lighting": "Overcast soft white light, blizzard visibility",

"atmosphere": "Cold, vast, lonely, epic",

"composition": "Extreme wide shot to show the massive scale of the gate vs the human",

"details": "Intricate runes carved into the rock, swirling snow, prayer flags flapping",

"text_elements": "Carved runes on the stone gate (unreadable ancient language)",

"technical": "Landscape photography, f/16 aperture for deep focus, matte painting aesthetic",

"trigger_word": ""

}

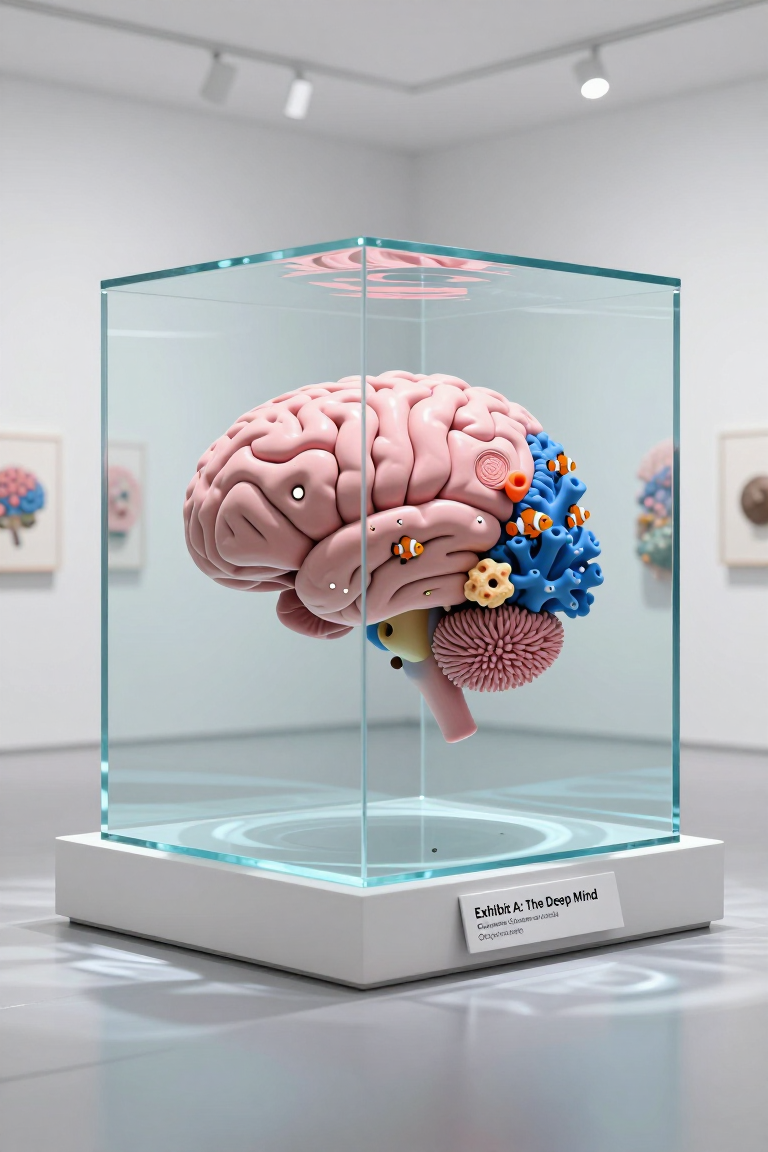

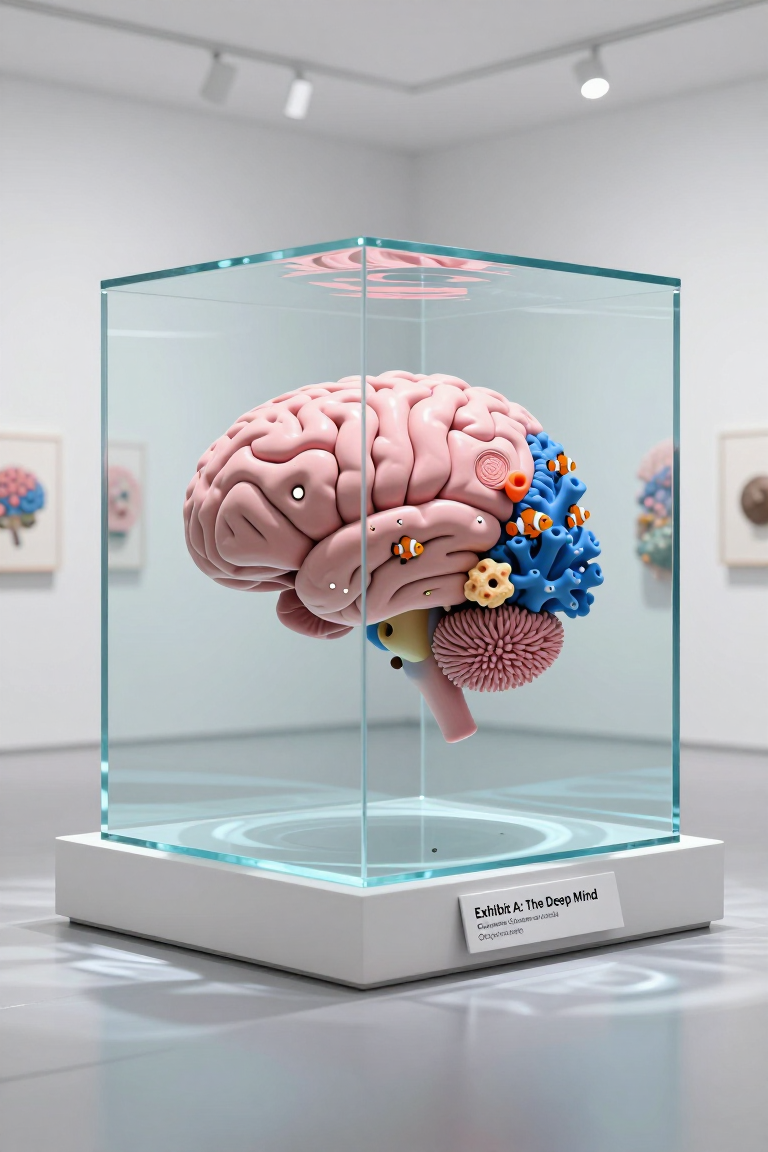

10. Conceptual & Surreal Test

What it tests: The model’s ability to merge impossible concepts into a coherent, believable image.

The Challenge: This is pure concept-blending. The brain should immediately read as recognizable anatomy while simultaneously being constructed from coral, anemones, and sponges. Water caustics on the gallery floor, refraction through the cube, and tiny clownfish swimming through the folds all add layers of technical difficulty. The placard text « Exhibit A: The Deep Mind » should be gallery-quality typography.

json

{

"subject": "A human brain made entirely of coral reef",

"appearance": "The shape of a brain but formed by pink and blue corals, anemones, and sponges",

"action": "Floating inside a cube of water",

"setting": "A minimalist white art gallery",

"lighting": "Studio gallery lighting, spotlights reflecting off the water cube",

"atmosphere": "Surreal, artistic, clean, intellectual",

"composition": "Centered medium shot", "details":

"Tiny clownfish swimming through the 'brain' folds, water caustics on the floor",

"text_elements": "Museum placard on the pedestal reading \"Exhibit A: The Deep Mind\"",

"technical": "3D render style, Cinema4D, Octane render, hyper-surrealism",

"trigger_word": ""

}

How to Use This Benchmark

- Copy the JSON prompts exactly into your Z-Image-Turbo workflow

- Use consistent settings (resolution, sampler, steps) across all 10 prompts

- Generate multiple iterations if you want to test consistency

- Share your results in the comments below with your settings

- Compare outputs with others to identify patterns and limitations

What to Look For

When evaluating your generations:

- Text legibility – Can you read all specified text elements clearly?

- Material accuracy – Do different materials (metal, fabric, skin, glass) look distinct?

- Physical plausibility – Do liquids, cloth, and motion follow realistic physics?

- Detail retention – Zoom in on small elements; do they hold up under scrutiny?

- Conceptual coherence – In surreal prompts, does the impossible still make visual sense?

This benchmark suite is a living document. As Z-Image-Turbo updates and evolves, rerunning these prompts will show exactly what’s improved. I encourage everyone to test these prompts and share results—both successes and failures—so we can collectively understand this model’s true capabilities.

Drop your generations in the comments, note your settings, and let’s build the most comprehensive Z-Image-Turbo evaluation database the community has ever seen.

Happy generating, and may your renders be glitch-free! 🚀

Last But Not least …

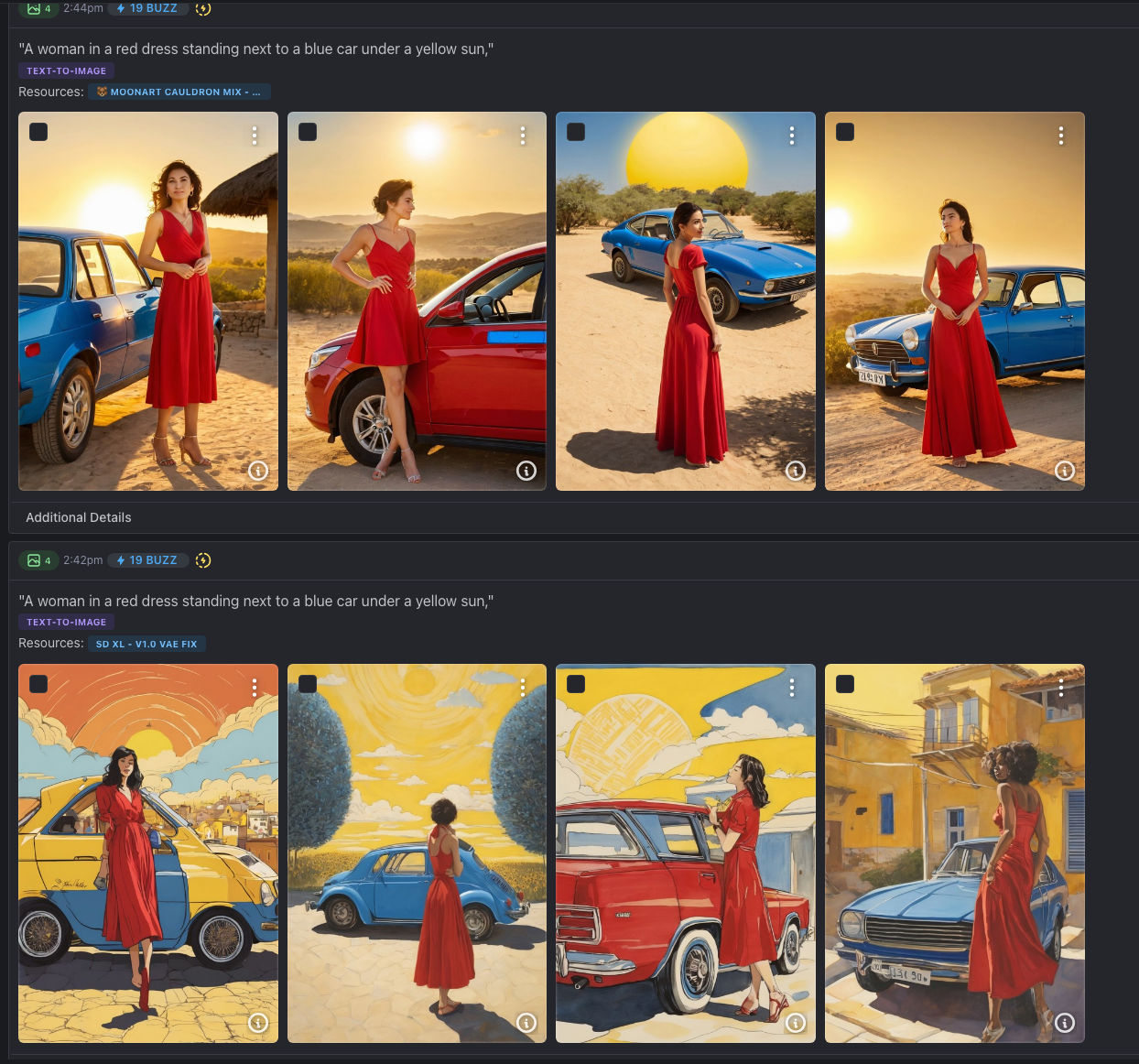

Z-Image-Turbo is a very low ressources model , generation cost are far far away from cost of a Flux.1 ( or Flux.2 ! ) generation and can be as low as 10 Blue BUZZ for a 1216×832 or 1024×1024 image

To demonstrate Z-Image-Turbo’s efficiency on consumer hardware, I ran all 10 benchmark prompts on my Mac M1 with 16GB shared RAM—a setup many creators already own:

Prompt Resolution Generation Time

Neo-Noir Window 1152×768 242.63s (~4m 3s)

Botanist Portrait 1152×768 246.84s (~4m 7s)

Art Deco Lobby 1152×768 247.92s (~4m 8s)

Motocross Action 1152×768 247.99s (~4m 8s)

Burger Drop 1152×768 252.81s (~4m 13s)

Dogs Playing Poker 1152×768 249.14s (~4m 9s)

Fashion Runway 1152×768 246.10s (~4m 6s)

Horror Bear 1152×768 232.02s (~3m 52s)

Himalayan Gate 1152×768 228.99s (~3m 49s)

Coral Brain 1152×768 228.15s (~3m 48s)

Average generation time: ~242 seconds (~4 minutes) on consumer hardware—without requiring a dedicated GPU with massive VRAM.

Cet article a été généré par Claude ^^ et annoté par mes petites mimines

Je le publie ici en premier avant publication sur civitai …

@+

Ouinche

J’aime ça :

J’aime chargement…